![]()

「HERP」は複数の求人媒体と自動連動する採用管理システムを軸とした、AIリクルーティングプラットフォームだ。2017年12月に発表された同サービスは、既存の求人媒体と情報を連携して応募を自動で登録し、一括管理できる仕組み。採用担当が行う事務作業の多くを自動化し、戦略的な採用活動に注力できるよう支援することを目的に開発されている。

同サービスを開発するHERPは3月12日、スタートアップの経営や採用戦略に携わる8名がパートナーとして加わり、経営に参画すると発表した。HERP PARTNERとして迎えられたのは、以下の8名。このうちエウレカ共同創業者の赤坂氏と西川氏は、HERPに合計数千万円規模の出資を行っている。

- 赤坂優氏(エウレカ 共同創業者/エンジェル投資家)

- 石黒卓弥氏(メルカリ HRグループ)

- 小澤政生氏(サイバーエージェント採用責任者)

- 河合聡一郎氏(ReBoost 代表取締役社長)

- 桑田友紀氏(サイバーエージェント 採用担当)

- 小泉文明氏(メルカリ 取締役社長兼COO)

- 高野秀敏氏(キープレイヤーズ 代表)

- 西川順氏(エウレカ共同創業者/エンジェル投資家)

HERPは2017年3月創業。代表取締役CEOの庄田一郎氏は、リクルートで新卒エンジニア採用などを担当したあと、採用広報担当としてエウレカに入社。エウレカでは「Couples」の事業担当者も務めていた。

庄田氏は「採用、HRの業界構造は60年ぐらい変わっていない。企業は工数をかけてエージェントや媒体に情報を提供し、採用が決まったらお金を払う。これでは情報は、エージェントや媒体に偏る。また求職者にとっても、企業選びはエージェントの持ってくる情報に限定された状況だ」と言う。

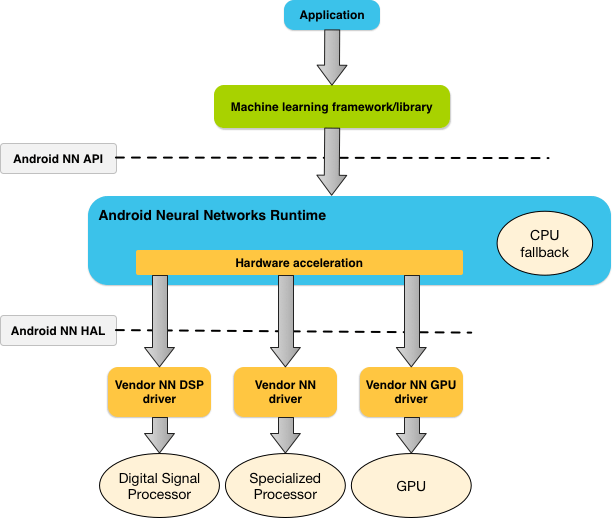

この状況を変えたい、と考えられたのが同社の掲げる「Open Recruiting API構想」だ。これは利用企業が持つ求人データ、応募する候補者データを、API経由で採用媒体やエージェントと適切にやり取りする、というもの。「金融業界ではマネーフォワードが『Open Bank API』を提唱してきた。その後、銀行が更新系APIの提供を始めたが、これは時代の流れ。採用業界でも同じことをやりたい」と庄田氏は語る。

「今後、採用にまつわる情報は複雑化していく。働き方改革で副業が広がり、新卒採用、終身雇用といった制度もなくなっていくだろう。また外国人の雇用も増えていくはずだ。そうなると、人事にかかるコストは膨らんでいく。これを見据えて、データのオープン化への対応を準備していく」(庄田氏)

庄田氏は「これまで変化のなかった採用業界で、既存の媒体がこれを推進するのには困難もあるだろう。採用業界の構造を中立な立場で変革して行く存在として、僕たちが担っていきたい」と話す。

「デジタル業界、ウェブ系企業では、データのオープン化にも理解があるところが多い。今回は、スタートアップ、ベンチャー企業のHRの権威や経営者の方に、この思想に共感し、参画してもらった。今後も、Open Recruiting API構想に協力するパートナーは増やしていきたい」(庄田氏)

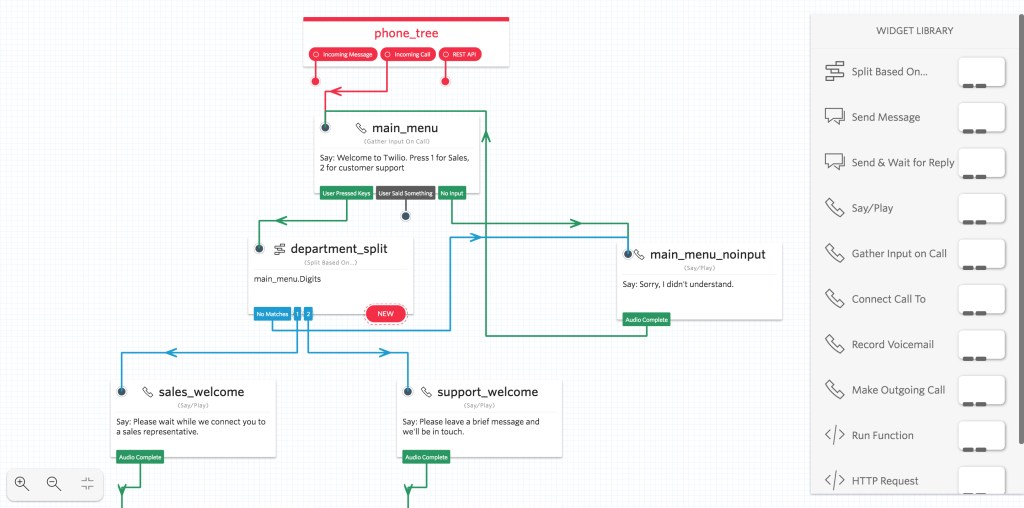

庄田氏はまた「直近では採用事務を自動化することを目指す。そのためには、まだまだツールが必要」として、その開発を進めていきたい、と話している。「採用担当者は、媒体の管理画面から手入力で候補者の情報をExcelに入力することも多い。それでは正確な候補者データを担保できない。まずは、正確なデータを企業が入手できるようにしたい」(庄田氏)

手入力やコピーペーストの登録による弊害はほかにもある。応募してきた候補者リストが、企業にデータとして集約されないケースだ。「人事担当者が媒体の管理画面上で確認し、その場で不採用メールを送る、ということはよくある。この場合Excelに転記されないので、面接フローに乗った人だけしか、管理できない。粒度のそろったデータにならないので、採用分析にも支障がある」(庄田氏)

また、パフォーマンスや早期離職の分析など、入社後にも採用時のデータは活用できる。「入口でデータを持っていなければ、そういった活用にはつながらない。HERPは媒体と自動連携することで、企業が手間をかけずにデータを入手できる機能を提供する」と庄田氏は説明する。

さらに将来的には、より深い分析も可能になるだろう、と庄田氏は述べている。「応募者側で言えば、レジュメと自分の情報を登録すれば、希望する企業の合格率が分かる、といったことも考えられる。企業側も、例えば1000万円をかけて財務担当を採用したい、となったときに、媒体ごとにいくらかければよいのか、AIを使って費用を最適化することもできるだろう」(庄田氏)

庄田氏は「広告で人材を獲得するときの効果測定は、マーケティングと一緒」と話す。「1人あたりいくらかかったのか、その後の効果はどうなのか。データがなければ分析、確認はできない」(庄田氏)

昨年12月にサービスの発表と同時に公開されたHERPのティザーサイトでは、ベータ版ユーザーの登録を募集している。庄田氏によると、これまでの3カ月で約400社の登録があったそうだ。「プロモーションを行わずにこの数字だったので、手応えはある」と庄田氏は言う。「ウェブサービスなどの企業のほか、大企業からの登録もあった。意外だったのは、弁護士事務所などの士業からの申し込みも結構あったことだ」(庄田氏)

HERPは現在、クローズドベータの形で数社に公開され、試用が始まっているとのこと。登録企業全体に公開されるのは、今春の予定だ。